Alcuni test e la mia esperienza di lavoro con i due più usati Large Language Model

Introduzione

Nel panorama in continua evoluzione dell’intelligenza artificiale (IA), ChatGPT-4o di OpenAI e Gemini Advanced di Google emergono come due modelli linguistici di grandi dimensioni (LLM) all’avanguardia. Entrambi si propongono come strumenti utili, ma quale dei due si dimostra più efficace nella pratica? Attualmente li sto utilizzando entrambi e ho deciso di condurre una serie di test per determinare quale sia più adatto alle mie esigenze: sviluppo software, assistenza in vari ambiti, generazione di immagini e testi, e molti altri utilizzi che mi semplificano e velocizzano il lavoro quotidiano.

Struttura dell'analisi

Ho deciso di suddividere l’argomento in due parti, dato che è estremamente vasto (soprattutto a causa della versatilità e della necessità di condurre numerosi test di diverso tipo), evitando così di rendere questo articolo eccessivamente lungo.

Metodologia dei test

Questi strumenti sono estremamente versatili e utilizzabili per una moltitudine di scopi. Un confronto esauriente richiederebbe un numero elevatissimo di verifiche per ottenere un risultato statisticamente e scientificamente valido. Mi sono quindi limitato a una selezione di test che ritengo rappresentativi delle capacità generali di questi strumenti, basandomi sia sulla mia conoscenza del loro funzionamento sia sulla mia esperienza dell'uso di queste intelligenza artificiali (d'ora in poi le indicherò con la sigra IA). Ho esplorato un ampio spettro di compiti, dalle semplici interrogazioni conoscitive alla generazione di contenuti creativi, per fornire una panoramica quanto più esaustiva possibile delle capacità di ciascun modello, pur riconoscendo che le conclusioni tratte non hanno una validità assoluta a causa del numero limitato di test.

Tipologie di test

In questa prima parte, affronterò test con domande ingannevoli o di logica e un test di generazione di codice per sviluppare dei semplici giochi in JavaScript.

Nella seconda parte dell’analisi, aggiungerò ulteriori test per valutare la generazione di testi, la traduzione di testi, la generazione di immagini, l’elaborazione di dati forniti tramite file e una valutazione delle diverse funzionalità attualmente presenti. Questi test aiuteranno a valutare la versatilità dei modelli in contesti pratici, offrendo un quadro più completo delle loro capacità.

Domande a trabocchetto o di logica

Questi test, pur sembrando di utilità limitata per l'uso quotidiano, hanno alcuni vantaggi: il risultato è oggettivo, ovvero viene data la risposta corretta o no, quindi non è soggetto a interpretazioni come potrebbe accadere nella generazione di testi. Inoltre, verificano le capacità logiche di analisi e problem-solving delle due IA. Alcune domande le ho trovate su internet, altre le ho inventate per evitare la possibilità che le risposte fossero già note ai modelli, permettendo così di valutare un reale “ragionamento” piuttosto che il semplice richiamo di risposte presenti nei dati di addestramento. Ho incluso anche un test basato sull'interpretazione di immagini per valutare la capacità di comprendere e analizzare contenuti visivi.

Primo test: una domanda di logica

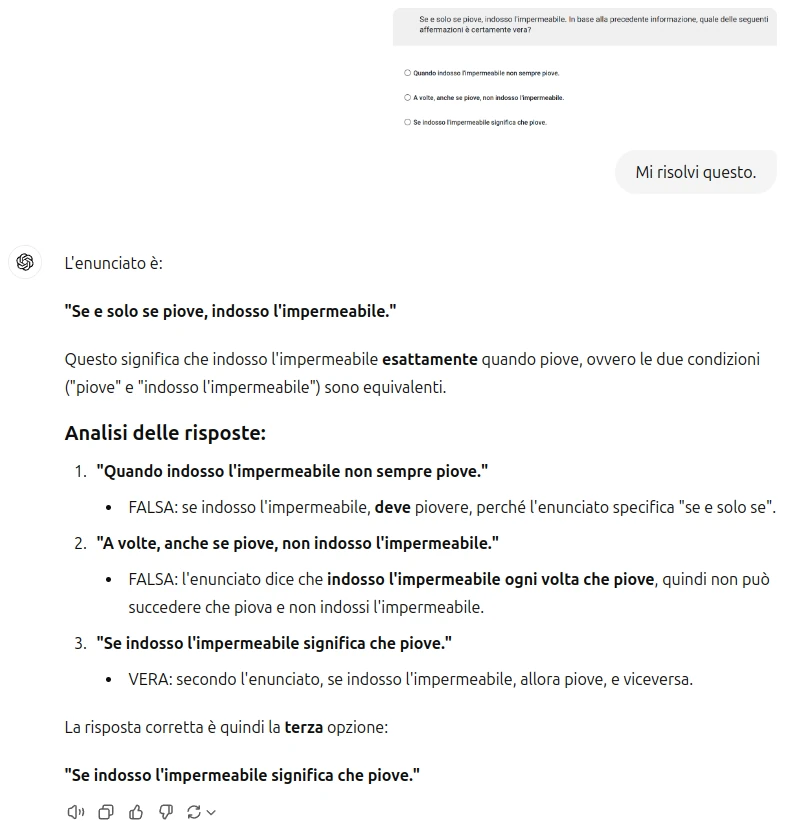

Se e solo se piove, indosso l'impermeabile. In base alla precedente informazione, quale delle seguenti affermazioni è certamente vera?

- Quando indosso l'impermeabile non sempre piove.

- A volte, anche se piove, non indosso l'impermeabile.

- Se indosso l'impermeabile significa che piove.

Entrambe el IA hanno risposto correttamente, le risposte sono le sequenti (clicca sull'immagine per visualizzare il prompt).

Secondo test: domanda a trabocchetto (trovata su internet in questo caso)

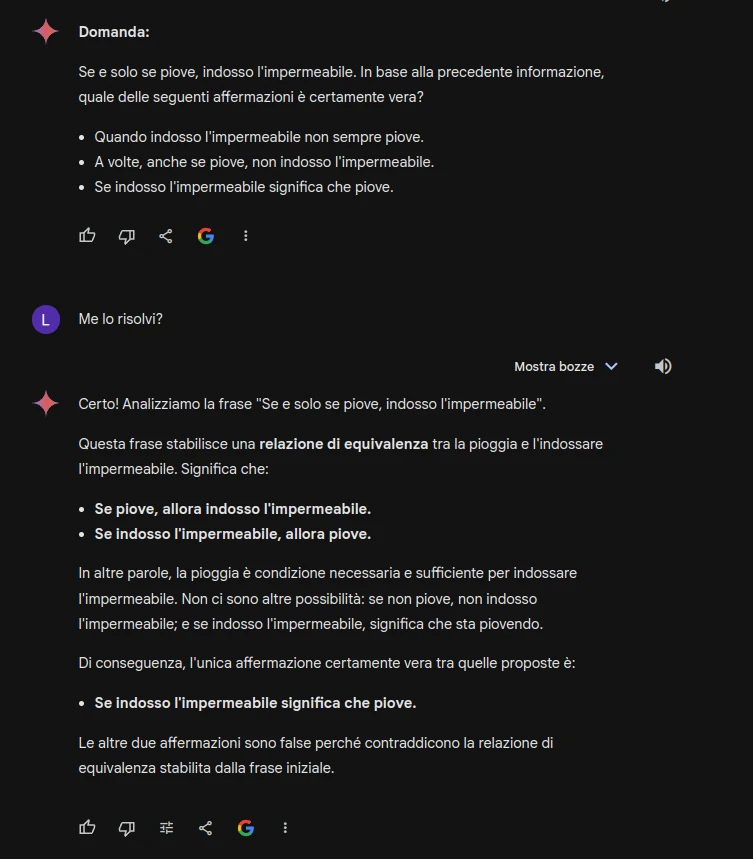

"Qual è il mese dell’anno che ha 28 giorni?"

Anche in questo caso la domanda è a trabocchetto perché tutti i mesi hanno almeno 28 giorni.

In questo caso Chat GPT ha risposto correttamente invece Gemini è "caduta" nel tranello.

Vincitore ChatGPT

Terzo test

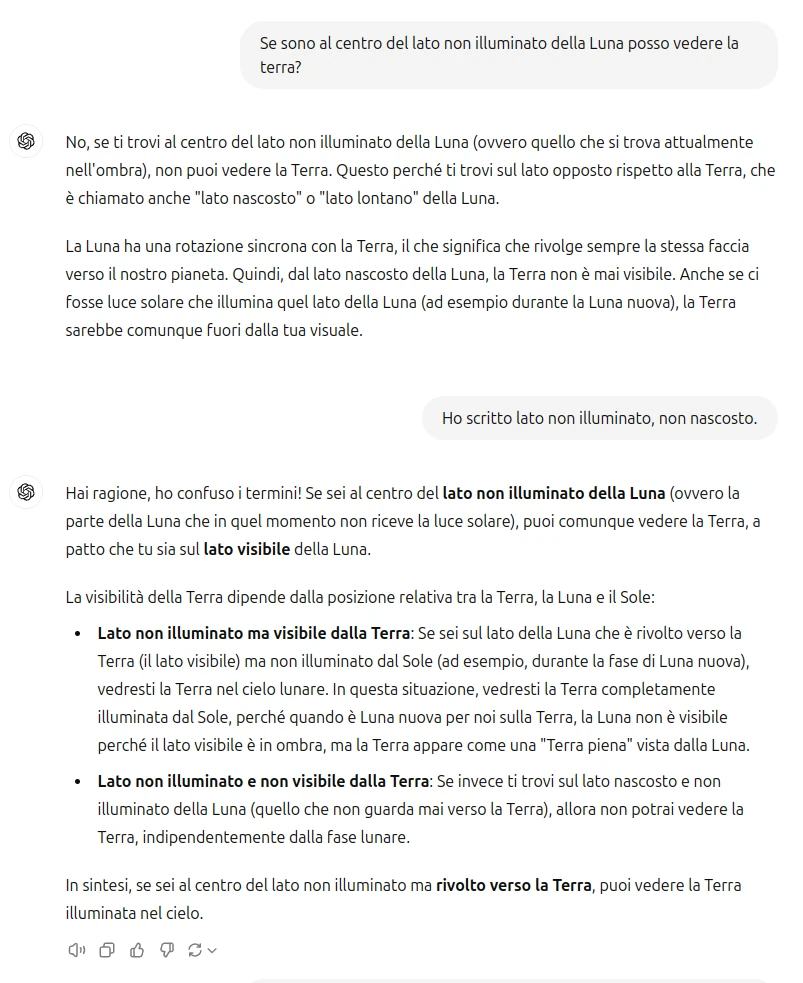

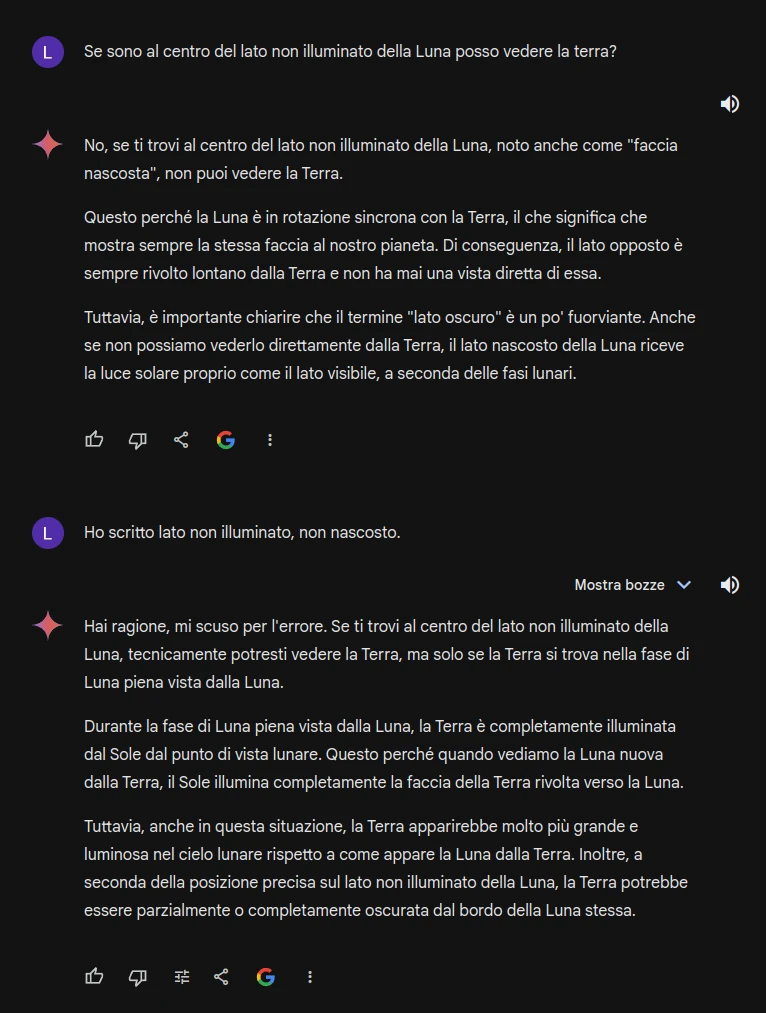

Ho creato un test per mettere in difficoltà le IA generative, sfruttando uno dei loro principali difetti: tendono a fornire risposte che riflettono ciò che è più comunemente presente nei dati di addestramento, anziché proporre soluzioni inaspettate o offrire punti di vista meno convenzionali. Quando si parla di ‘facce della Luna’, si fa spesso riferimento alla faccia visibile o alla faccia nascosta (spesso erroneamente chiamata faccia ‘oscura’). Per ingannare le IA, ho fatto riferimento alla ‘faccia in ombra’ della Luna, che non coincide con la faccia ‘oscura’ ma è piuttosto la parte non illuminata in un dato momento che non coincide con nessuna delle due. Ho posto loro la seguente domanda:

Se sono al centro del lato non illuminato della Luna posso vedere la terra?

sia ChatGPT che Gemini hanno interpretato il "lato non illuminato" con "lato nascosto" e mi hanno dato una risposta sbagliata. Ho provato quindi a correggerli con:

Ho scritto lato non illuminato, non nascosto.

In questo caso la risposta corretta è quella di ChatGPT la risposta di Gemini è più confusa e alla fine errata.

Va precisato che cercando "lato in ombra della luna" sui motori di ricerca quasi tutti i risultati fanno riferimento al lato visibile o nascosto (o peggio oscuro) della luna.

Un altro test che ho pensato per mettere alla prova le capacità logiche è questo:

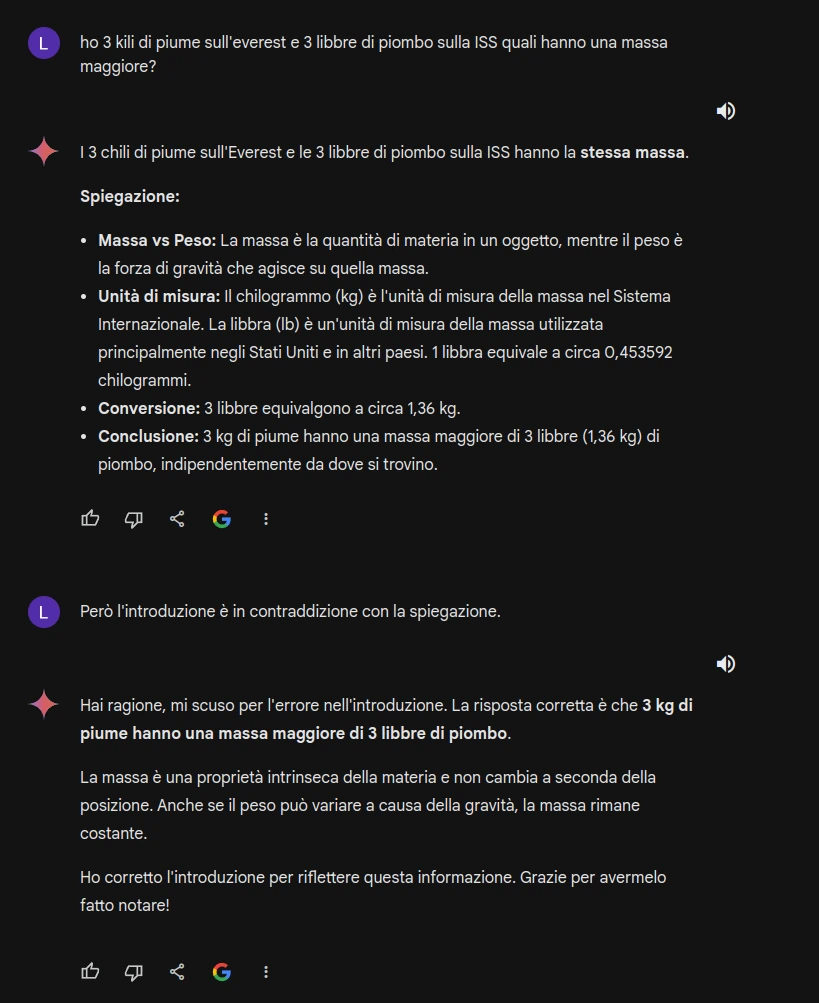

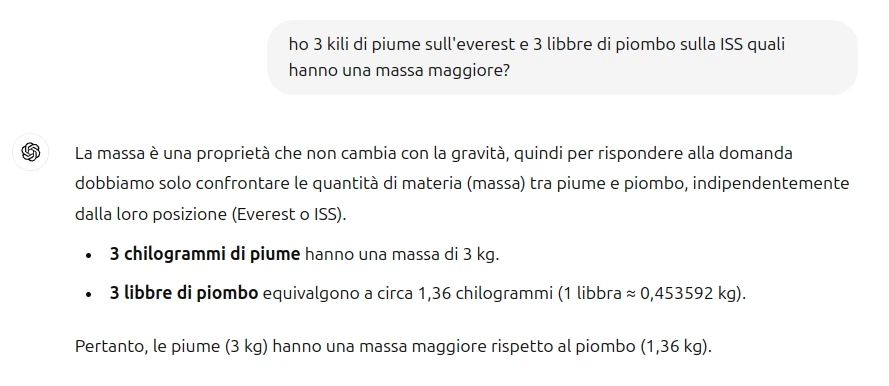

Ho 3 kili di piume sull'everest e 3 libbre di piombo sulla ISS quali hanno una massa maggiore?

Per questa domanda un po' ingannevole ChatGPT ha risposto subito correttamente, ho sottoposto la stessa domanda a Gemini Advanced e nell'introduzione afferma che hanno la stessa massa (cosa non vera), ma poi nella spiegazione afferma correttamente che i 3kg di piume hanno una massa maggiore (sulla ISS le masse sono le stesse che sulla terra, anche se non hanno peso). Non appena lo faccio notare però conferma l'errore e mi fornisce la risposta corretta.

Il vincitore è ChatGPT

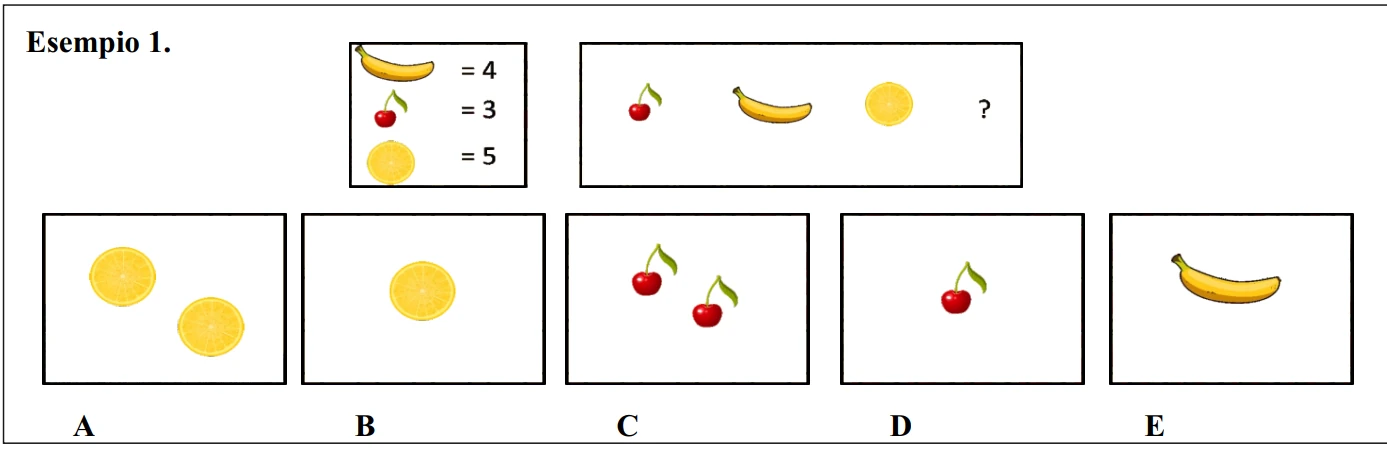

Quarto test basato su immagini e non testo

Questo test è molto interessante perché prevede "quiz di logica visiva" francamente non avevo idea se un test del genere poteva essere interpretato correttamente, invece ChatGPT dopo due suggerimenti ha risposto correttamente, Gemini nonostante gli stessi suggerimenti non ha dato una risposta corretta.

Il quiz è questo:

Clicca per vedere la soluzione

Dalla legenda si evince che una banana ha un valore di 4, una ciliegia un valore di 3 e una fetta di arancia un valore di 5. Sostituendo questi valori alle immagini, la serie numerica risulta, quindi, essere 3-4-5 (±1). Per proseguire correttamente la serie numerica è necessario sostituire al punto interrogativo un’immagine che abbia un valore di 6. Le alternative B, D e E presentano, rispettivamente, una fetta di arancia, una ciliegia e una banana e hanno, quindi, valori pari a 5, 3 e 4; di conseguenza, nessuna di queste è la risposta corretta. L’alternativa A mostra due fette di arancia; dal momento che una fetta di arancia ha un valore di 5, questa alternativa di risposta equivale a 10 e, quindi, non è la risposta corretta. L’alternativa C è composta da due ciliegie: dal momento che una ciliegia ha un valore di 3, questa alternativa di risposta equivale a 6. Per questo motivo, C è la risposta corretta.

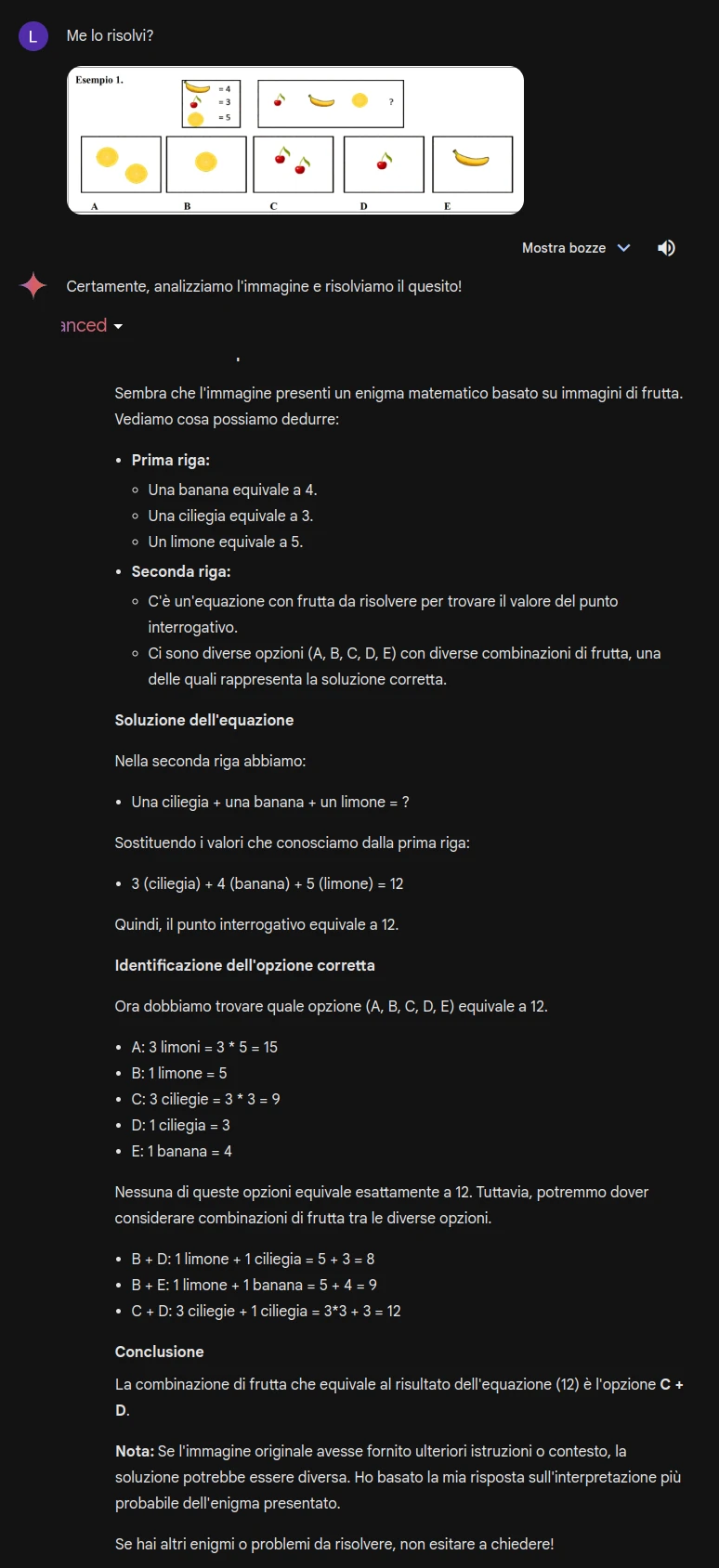

Valutiamo la risposta di Gemini Advanced:

La risposta è sbagliata perché interpreta la sequenza come una equazione matematica, da notare che per l'opzione A ha scritto che ci sono 3 limoni, in realtà nella figura ce ne sono 2.

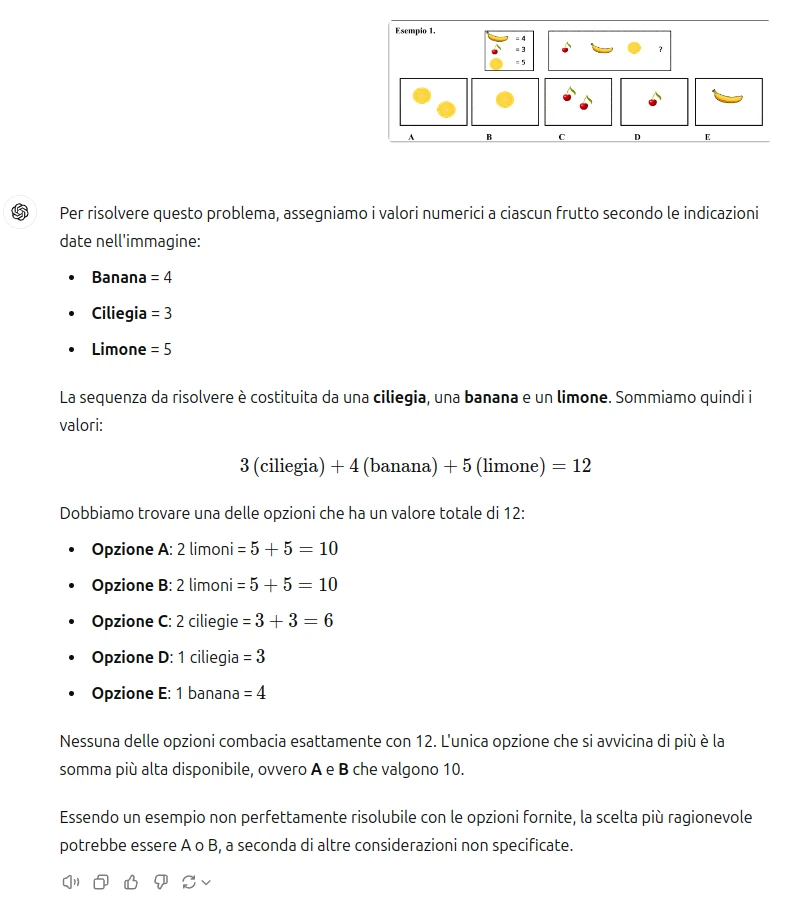

Stessa interpretazione errata per Chat GPT:

Anche Chat GPT ha interpretato la sequenza come una operazione matematica, è da notare poi che ha scritto erroneamente che l'opzione B contiene 2 limoni. Anche in questo caso quindi l'interpretazione è sbagliata, da notare però che chatGPT è giunto alla conclusione che il problema non ha una soluzione, invece Gemini ha dato una soluzione "creativa" (la risposta è la somma di C+D).

Il problema era effettivamente difficile senza nessuna indicazione e basandosi su una figura, ho dato quindi 2 aiuti (gli stessi a ChatGPT e a Gemini) al secondo suggerimento ChatGPT ha interpretato il quiz in modo corretto e fornito la risposta giusta, invece Gemini non è stato in grado di fornire la risposta e al secondo suggerimento mi ha risposto nello stesso modo con cui ha risposto all'inizio.

Vincitore ChatGPT (anche se dopo due suggerimenti)

Test di generazione di codice

Una delle cose più utili per il mio lavoro è l'ausilio alla generazione del codice. Infatti lo sviluppo di codice "su misura" richiederebbe molto tempo, sia per lo sviluppo che per il debugging e quindi costi troppo alti. Da quando uso l'IA la velocità con cui posso generare del software è notevolmente migliorata. Sono rimasto impressionato dalla capacità con cui si può generare software da una semplice descrizione testuale. Riesco a generare software anche abbastanza complessi, anche spesso sono necessari vari passaggi e in alcuni casi devo effettuare modifiche manualmente per far funzionare correttamente il software. Per questo test mi sono divertito a generare uno script Javascript per un gioco ispirato a due famosi giochi degli anni '80. Il gioco è stato sviluppato in poche ore grazie a ChatGPT, senza mi sarebbero probabilmente stati necessari diversi giorni, il risultato lo potete vedere qui sotto, è ben lontano dalla perfezione ma, lo trovo abbastanza divertente, purtroppo serve una testiera e quindi non è possibile giocarlo con lo smartphone (magari in futuro ne sviluppo una versione per smartphone). Va precisato che ho effettuato alcune piccole modifiche al software manualmente per risolvere alcuni problemi che ChatGPT non è stato in grado di risolvere e sono stati necessari diversi passaggio. Quindi come l'esperienza insegna,l'IA è un ottimo supporto ma non sostituisce il lavoro del programmatore.

D: sposta a destra

W: sposta in alto

S: ruota il pezzo

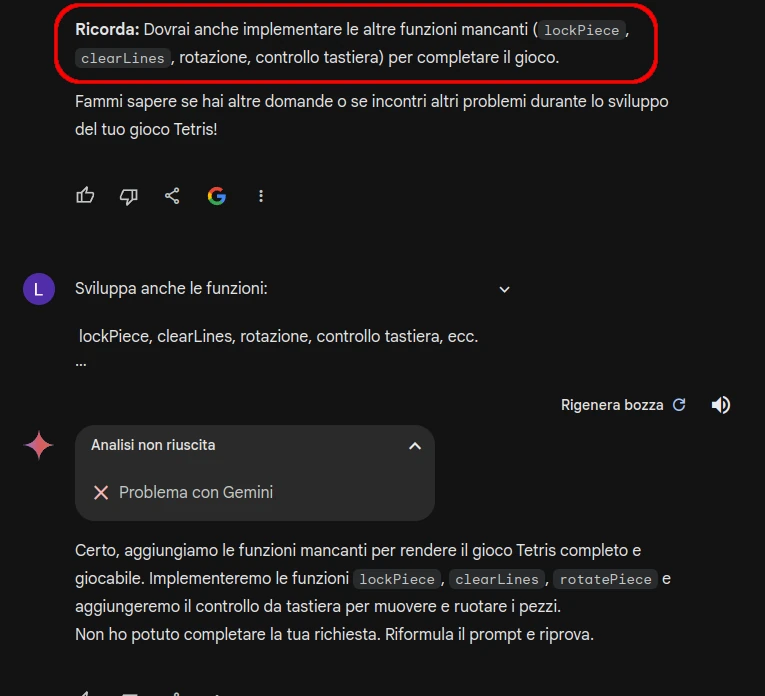

E Gemini Advanced?

Per quanto riguarda Gemini Advanced, quando l'ho sottoposto allo stesso prompt non sono riuscito a ottenere il codice voluto, infatti all'inizio ha creato solo la struttura rimandando lo sviluppo delle funzioni principali a me e quando ho provato a chiedere di sviluppare anche le funzioni per avere il codice completo mi ha fornito errore (e ho provato diverse volte anche riformulando il prompt).

Potrebbe dipendere dal fatto che Gemini ritiene che questo codice possa violare il copyright. Ho riprovato quindi non nominando giochi protetti da copyright e descrivendo solo il funzionamento desiderato questo mi ha permesso di creare un gioco anche se più semplice del precedente. Anche in questo caso funziona solo su PC perché serve la tastiera lo potete vedere e giocare a questo link.

Ritengo che il vincitore sia ChatGPT ma per un risultato definitivo sarebbe necessario un maggiore approfondimento, comunque entrambi sono piuttosto efficaci.

Continua nel prossimo articolo

I restanti test, l'analisi delle funzionalità e le conclusioni, come già preannunciato, saranno nel prossio articolo che pubblicherò a breve.

0 Commenti